Auf die Grösse kommt’s an: Geschichte der Festplatte

Die Speicherung von Daten ist in der IT von enormer Wichtigkeit. Im Alltag geht das gerne vergessen und wird als selbstverständlich angesehen. Dabei hat die Harddisk die Benützung von Computern revolutioniert: Eine Geschichte von Lochkarten, Platter und ganz vielen Formaten.

Als Kind der 80er und 90er vermisse ich bei heutigen PCs und Notebooks mit SSD das charakteristische Klicken und Knacken beim Booten mit einer HDD. Damals eine wahre Kakofonie, heute eine Geräuschfolge, die Kindheits-/Jugenderinnerungen hervorruft. Und irgendwie war das Geräusch ja auch beruhigend, so konnte ich auch akustisch sicher sein, dass mein PC noch läuft. Mit einer SSD komme ich leider nicht mehr in diesen Genuss.

Die Festplatte ist mir durch meinen Arbeitsalltag am Notebook schon fast vergessen gegangen. Dabei hat der Massenspeicher dem PC ja erst den Weg geebnet. Bevor es die HD gab, wurden Daten vornehmlich auf Lochkarten gespeichert. Als deren Erfinder gilt Herman Hollerith.

Mit Löchern die Welt erobern

Der US-Amerikaner Hollerith war als «special agent» bei der Volkszählung von 1880 tätig. Dabei sah er sich dem Problem der Datenauswertung konfrontiert. Die mechanischen Hilfsgeräte dieser Zeit hatten mit der enormen Papiermenge ihre Mühe. Es dauerte acht Jahre, bis die Ergebnisse komplett vorlagen. Um dieser Herausforderung besser Herr zu werden, entwickelte er ein Lochkarten-System, das er 1889 zum Patent anmeldete.

Lochkarten-Systeme gab es schon vor Hollerith. Sein System war aber als erstes zum Speichern von Daten gedacht. Es bestand aus Stanzer, Leser mit Tabellierer und Sortierer. Der Stanzer prägte der Karte die Daten ein. Der Leser tastete die gelochte Karte ab und gab diese über elektrische Impulse an die Zählwerke des Tabellierers weiter. Der Sortierer bildete nach bestimmten Kriterien Stapel. Holleriths Maschine liess sich mit austauschbaren Rahmen beschränkt programmieren. Dadurch konnte beispielsweise beim Tabellierer die Auswertung der Karteninhalte festgelegt werden.

Quelle: Heinz Nixdorf MuseumsForum (HNF)

Dank Holleriths System lief die Volkszählung 1890 einiges schneller ab. Nach drei Monaten konnten bereits erste Daten präsentiert werden und nach einem halben Jahr war die Zählung abgeschlossen. Der studierte Bergwerksingenieur gründete in der Folge eine eigene Firma, welche später aufgekauft und in IBM umgetauft wurde.

1928 erhielt die Lochkarte ihr standardisiertes Format. Die Funktion ist schnell erklärt: In die Karten werden Löcher gestanzt. Diese Löcher sind codierte Zeichen. Auf einer Karte hat nur eine bestimmte Anzahl Zeichen Platz. Deshalb sind bei grösseren Daten/Anwendungen mehrere Karten notwendig. Die moderneren Lochkarten hatten ein Fassungsvermögen von 80 Byte.

Erste HDD

Quelle: Wikipedia

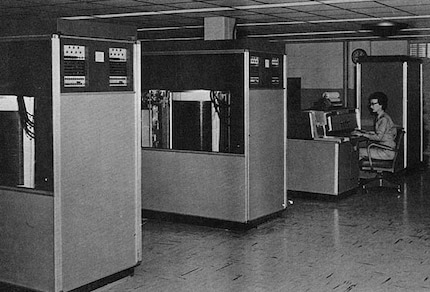

Da das Lochkartensystem an seine Grenzen kam, musste eine neue Lösung für den Massenspeicher her. Durchgesetzt hat sich die Festplatte. 1956 brachte IBM den 305 RAMAC auf den Markt. In ihm war eine 5-MB-Festplatte verbaut. Diese 5 MB kamen auf 50 beidseitig magnetisierbaren Scheiben (Platter) à je 24 Zoll Durchmesser zu liegen. Das brauchte dann auch entsprechend Platz: Der rund eine Tonne schwere Massenspeicher war etwa 1 Meter 70 hoch, 1 Meter 50 lang und 75 Zentimeter tief. Bei diesen Dimensionen mussten die Festplatten mit Lastwagen und Gabelstapler geliefert werden.

Die Funktionsweise war bereits bei der ersten Festplatte ähnlich wie heute noch. Die Aluminiumplatten waren auf beiden Seiten mit einer Magnetschicht überzogen. Sie kamen in einem Abstand von acht Millimetern übereinander zu liegen. Dabei rotierten sie mit bis zu 1200 rpm. Zwei Arme mit Lese- und Schreibköpfen fuhren den Plattenstapel vertikal ab und Lasen oder Beschrieben den jeweiligen Datenbereich.

Weiterentwicklungen

Der IBM 1301 war der nächste grössere Schritt. Beim 1961 erschienenen Modell gab es für jede der 25 Platter einen Lese-/Schreibekopf, der mit 1800 rpm drehte. Zudem bot er mit 26 Tausend Bits pro Zoll 13 Mal die Speicherkapazität des RAMAC. Ein Jahr später kam bereits die Weiterentwicklung des IBM 1301, der 1311, auf den Markt. Der Massenspeicher wurde damit so etwas wie mobil: Die sechs 14 Zoll Platten konnten ausgetauscht werden. Auf einem solchen Plattenpaket wurden 2.6 MB Daten gespeichert und es wog nur rund 4.5 Kilogramm.

Quelle: computerhistory.org

Mit dem IBM 3340 Speichersystem, Codename «Winchester» wurden diverse Innovationen eingeführt. So werden auch heute noch alle gekapselten Plattenlaufwerke – Laufwerke, deren Mechanik vor Umwelteinflüssen geschützt ist –genannt. Woher der Codename genau kam, ist nicht bekannt. Eine Geschichte besagt, dass er von der Winchster Waffe 30-30 stammt. Dies aufgrund der Speicheraufteilung 30 MB und 30 MB (obwohl das nicht korrekt ist). Eine andere Begründung für den Namen ist, dass das Laufwerk am Standort Winchester produziert wurde. Die Platten wurden in auswechselbaren Modulen verbaut. In diesen waren die Schreib-/Leseköpfe fix integriert und deshalb einiges kleiner und leichter als die bisherigen Köpfe. Das erlaubte eine massive Erhöhung der Speicherkapazität, da Toleranzen bei der Kopfjustierung zwischen einzelnen Laufwerken und verschiedenen Modulen entfielen. Die Speicherkapazität betrug je nach Modul entweder 35 MB oder 70 MB. Bis 1980 konnte IBM die Speicherkapazität ihrer Systeme auf 2.52 GB erhöhen.

Massenspeicher für PCs und Notebooks

Bis in die 1970er waren Computer riesige Geräte, die vor allem in Unternehmen, Universitäten oder sonstigen Institutionen zum Einsatz kamen. Die Preise für Elektronik-Komponenten fielen aber im Verlauf der Jahre. Das ermöglichte neue Absatzmärkte. Computer fanden auch immer mehr im privaten Bereich Verwendung. Die Möglichkeit, Daten auf einem Träger abzulegen, befeuerte diese Entwicklung. Einen enormen Beitrag dazu lieferte das damals junge Startup Seagate. Es entwickelte eine 5.25 Zoll grosse Festplatte mit 5 MB Speicherplatz. Und das für damals günstige 1500 Dollar. Die Seagate ST-506 machte es möglich, das Betriebssystem, die Software und Daten auf einem Medium abzulegen. Es war nicht mehr länger nötig, für jede dieser Aufgaben jeweils eine Diskette einzulegen.

Quelle: computerhistory.org

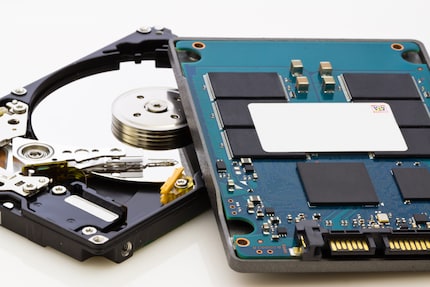

In der Folge wuchs die Speicherkapazität und die Festplatten wurden kleiner. 1991 brachte Toshiba eine 2.5 Zoll grosse Festplatte raus. Heute finden sich hauptsächlich 3.5 Zoll oder 2.5 Zoll Varianten. Augenscheinlich verändert haben sich vor allem die Interfaces: IDE, SCSI, ATA, SATA, PCIe. Mit jedem neueren Interface lassen sich Daten schneller und zuverlässiger übertragen. Die Drehgeschwindigkeiten der Platter wurden erhöht, um mehr Performance zu erhalten. Die Speicherkapazität wurde unter anderem durch mehr Platten (beispielsweise Glaskeramik- statt Aluminiumplatter, da sie dünner gebaut werden können) auf gleichem Raum oder einem neuen Schreibverfahren erhöht: Vom Longitudinal Recording (LTR) über Perpendicular Magnetic Recording (PMR) bis zu Shingled Magnetic Recording (SMR). Mit SMR und Helium- statt Luft-Füllung können zurzeit 14 TB grosse Festplatten erreicht werden.

HDD vs. SSD

Der Untergang der Festplatten wird verschrien, seit SSDs in vernünftiger Speichergrösse erschwinglich sind. Obwohl die SSD-Technologie beinahe so alt ist wie die HD, wurde sie erst mit dem Aufkommen von flash basierten SSDs zur wirtschaftlichen Konkurrentin. HDDs bieten zurzeit noch mehr Speicher für weniger Geld. SSDs verfügen aber bereits jetzt über mehr Speicherkapazität. Demnächst kommen Modelle mit 100 TB auf den Markt. Für den Normalverbraucher sind diese aber wohl noch einige Zeit unerschwinglich (mit Preisen im mittleren fünfstelligen Bereich). Die immer grösseren Speicherkapazitäten der SSDs werden deren Preise weiter drücken. Der Preisunterschied pro GB zwischen HDD und SSD wird künftig immer kleiner werden.

Da HDDs mehr Speicher fürs Geld bieten, eignen sie sich zurzeit auch noch besser für Server/NAS. Zudem kommt es beim Netzwerkspeicher vor allem auf die Geschwindigkeit der Verbindungstechnik an. Bei einem 1-Gbit-Netzwerk geht der Geschwindigkeitsvorteil einer SSD bei der Übertragung verloren. Es bräuchte schon ein 10-Gbit-Netzwerk, damit eine SSD im NAS Sinn macht.

Zukunft der HDD

Der Speicherbedarf ist zurzeit so gross, dass er alleine mit SSDs nicht gedeckt werden kann. In sieben Jahren sollen erst zehn Prozent des weltweiten Bedarfs durch Flash-Speicher gedeckt werden. Festplatten werden also auch weiterhin eingesetzt und es ist notwendig, ihre Kapazitäten zu erhöhen. Eine einfache Möglichkeit die Speicherkapazität von Festplatten zu steigern ist, sie höher zu bauen. Dadurch passen mehr Platter in die Gehäuse. Nebst dieser relativ simplen Kapazitätssteigerung, wird rege an neuen Festplattentechnologien geforscht.

Zurzeit sind mehrere Festplatten-Technologien in der Entwicklung. Zwei vielversprechende stehen kurz vor der Marktreife: Western Digital arbeitet an MAMR und Seagate an HAMR. Beim Heat Assisted Magnetic Recording heizt ein Laser das zu beschreibende Magnetmaterial kurz auf. Dann wird es beschrieben und kühlt wieder ab. Dank der Erwärmung ist eine geringere Feldstärke zum Beschreiben nötig. So werden die Köpfe etwas dünner und dadurch auch die Spuren, sprich: mehr Platz zum Schreiben auf gleichem Raum. Microwave Assisted Magnetic Recording geht in eine ähnliche Richtung. Hier arbeitet ein Mikrowellensender am Schreibkopf. Dieser braucht so weniger magnetische Feldstärke, um die Platter-Oberfläche zu magnetisieren.

Durch die neuen Technologien sollten Festplatten mit 100 Terabyte möglich sein. Das dürfte nach aktuellen Prognosen 2025 so weit sein. Die HDD wird uns also sicher auch noch einige weitere Jahre als Massenspeicher dienen. Zumindest so lange, bis SSDs mehr Speicher für weniger Geld als HDDs liefern.

65 Personen gefällt dieser Artikel

Technologie und Gesellschaft faszinieren mich. Die beiden zu kombinieren und aus unterschiedlichen Blickwinkeln zu betrachten, ist meine Leidenschaft.